Il manuale segreto di Facebook che regola il discorso politico mondiale

Dopo le accuse di essere responsabile della proliferazione di bufale e incitamento all’odio, Facebook sta cercando di vigilare sui contenuti degli utenti. Per continuare ad espandersi, il social network non può permettersi di avere la reputazione di un luogo pericoloso. Per questo, l’azienda di Menlo Park ha deciso di passare al setaccio tutto il contenuto prodotto dai suoi 2 miliardi di utenti.

Secondo le informazioni ottenute dal New York Times, una squadra di 7500 moderatori elimina post su post, seguendo le istruzioni riportate su un mosaico confuso di Power Point e documenti Excel. Queste istruzioni sono elaborate da qualche decina di dipendenti di Facebook ogni settimana, che mirano a stabilire quali siano i post che incitano all’odio, quali le voci pericolose.

Il quotidiano americano ha ottenuto queste informazioni da un dipendente, spinto dalla paura che il social network fondato da Mark Zuckerberg eserciti troppo potere, con troppa poca supervisione, commettendo troppi errori. Secondo il Times queste regole, gelosamente custodite, rendono di fatto Facebook “l’arbitro del dibattito politico mondiale”.

Dopo aver avuto accesso ai documenti, i giornalisti confermano le incongruenze: notano ad esempio, che è stato richiesto ai moderatori di rimuovere alcuni appelli alla raccolta di fondi per le vittime di un vulcano in Indonesia solo perché uno degli sponsor dell’iniziativa compariva nella lista nera interna a Facebook.

In Birmania, un errore burocratico ha permesso invece a un gruppo estremista, accusato di apologia di genocidio, di restare sulla piattaforma per mesi. Inoltre, in India i moderatori hanno accidentalmente eliminato commenti solo perché criticavano la religione.

Le ragioni di queste imprecisioni sarebbero due: le persone che stabiliscono le regole cercano di creare risposte semplici del tipo “si/no” a domande complesse; e i moderatori – che devono obbedire ciecamente – sono assunti tramite agenzie indipendenti che usano spesso manodopera non qualificata, che non sempre parla la lingua utilizzata nelle pubblicazioni, e deve ricorrere a Google Translate. I moderatori hanno riferito al Times che dispongono solamente di 8/10 secondi per giudicare se un post vada eliminato o meno.

Credits: New York Times

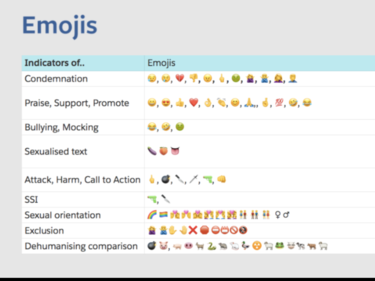

A proposito di hate speech, i post possono essere classificati secondo tre gradi di “gravità” e i moderatori devono tenere a mente liste come quella dei “sei confronti de-umanizzanti” (ad esempio, paragonare gli ebrei a dei ratti).

Esiste inoltre una tabella Excel che categorizza tutte le figure che promuovono discorso di odio, e i moderatori sono incaricati di rimuovere qualsiasi contenuto inneggi a questi gruppi o personalità. Il Times nota come in alcuni Paesi – dove i gruppi estremisti sono numerosi e i governi meno attenti – le organizzazioni e le personalità messe al bando siano poche.

Inoltre, alcune tra le organizzazioni messe al bando, come il partito greco di estrema destra Alba Dorata, siedono in Parlamento. Il Times fa notare come, in alcuni Paesi, eliminare qualsiasi riferimento a un banner estremista significhi mettere a tacere una grandissima parte dell’opinione pubblica.

Credits: New York Times

Il problema è riassunto dalla direttrice esecutiva di Facebook Monika Bickert: «C’è una vera tensione tra l’avere sfumature che si applicano a ogni situazione e delle norme che possiamo far rispettare accuratamente e spiegare in modo semplice».

L’impossibilità di avere una regola per ogni situazione lascia molto spazio alla soggettività, così Facebook si sta introducendo in dibattiti politici delicati, talvolta in modo un po’ maldestro. Secondo il Times, Facebook, da un intento di sanzionare gli estremi, è arrivato a regolare il discorso politico stesso.

In assenza di un governo o di istituzioni che determinino delle linee guida, l’azienda gode di moltissima libertà. Il social network ha, per esempio, rimosso dei post in cui l’amministrazione Trump si scagliava contro una carovana di migranti, e ha lasciato sulla piattaforma lodi ai talebani, purché esprimessero posizioni favorevoli a una tregua.

Nella corrispondenza ottenuta dal quotidiano newyorkese emerge anche che per Facebook, gli interessi in gioco vanno oltre la protezione degli utenti: nella moderazione del dibattito politico in Pakistan, ad esempio, la direzione della piattaforma ha espresso riserve riguardo interventi che potessero mettere a rischio la reputazione del social network e dunque il successo del business.

Un ulteriore conflitto di interessi è creato dal fatto che Facebook si basa su un algoritmo che tende a fare emergere e promuovere il contenuto più provocatore, che a volte è lo stesso che la piattaforma afferma di voler eliminare.