Intelligenza artificiale, parla l’italiano che sta conquistando il settore: «Il controllo e il guizzo restano degli esseri umani»

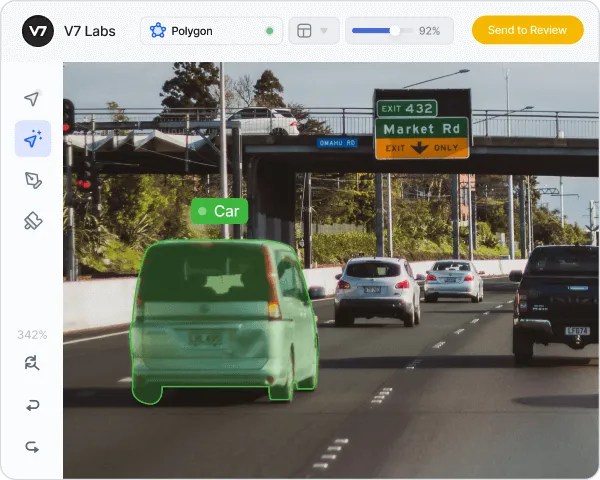

Alberto Rizzoli è nato a Roma, 29 anni fa. Vive a Londra e dal 2018 è amministratore delegato di V7, compagnia che opera nel campo dell’intelligenza artificiale che recentemente ha ottenuto il suo secondo finanziamento di venture capital: 33 milioni di dollari. «Dovrebbero darci spazio per far crescere la compagnia nell’arco dei prossimi due anni» – spiega a Open – «sono fiducioso, è un grande risultato soprattutto in questo inverno delle compagnie tech che si vedono costrette a ridimensionare». V7 è una piattaforma che consente ai modelli di intelligenza artificiale (AI) di lavorare molto più in fretta. La computer vision è quella branca dell’AI che si occupa di riconoscere gli oggetti all’interno delle immagini. Se normalmente degli operatori umani devono spiegare all’AI la natura di ogni oggetto in un’operazione chiamata etichettatura, V7 permette di velocizzare questo processo lasciando che sia l’AI stessa a etichettare gli oggetti, per poi far controllare il tutto agli esseri umani, che devono così svolgere solo una minima parte del lavoro.

Come è nata la tua passione per l’AI?

«Ho sempre avuto la passione di smanettare i computer. Nel 2013 sono andato a fare la Business School a Londra: un corso inutile sia per il business, sia per la tech. Però qui a Londra ho conosciuto Simon, il mio socio svedese. Con lui ho fatto un hackathon, una sorta di maratona per programmatori: ci si mette tutti assieme e si scrive un programma in 24 ore senza pause. Noi abbiamo sviluppato un piccolo programma per usare le tv dei pub come dei videogiochi arcade. La cosa bella era che il telefono diventava il controller del gioco. Ci siamo divertiti moltissimo, da lì è nata la nostra amicizia, e abbiamo sempre collaborato. Dopo sono andato a Mountain View, in California, per partecipare a un programma internazionale al NASA Ames Research Center. Lì ho iniziato a lavorare con l’AI. Era il 2015, quindi tante applicazioni che oggi diamo per scontate all’epoca non c’erano»

E qui è nato il tuo primo progetto?

«Sì, con Simon ho fondato Aipoly. Un’app per ipovedenti che inquadrando un oggetto con la fotocamera del telefono lo riconosce e lo descrive ad alta voce a chi la usa. Ora l’app non è più disponibile ma era simile al Google Lens di adesso. Sapeva individuare il colore di un oggetto e riconoscere 5 mila categorie. Molte persone lo usavano per fare la spesa. Presto ci siamo resi conto che per fare la differenza dovevamo puntare ad altro, a immagini che su internet non ci sono».

In che senso?

«Se pensi a un grande medico o un grande avvocato, la loro forza sta nel vedere quello che gli altri non vedono, che sia una massa tumorale nascosta o un cavillo che ti permette di vincere una causa. Noi dovevamo fare lo stesso: ai professionisti non interessa che l’AI sappia riconoscere cani e gatti. Serve vedere quali parti di un motore sono uscite difettose da una fabbrica, capire quale dente è cariato, trovare le cellule cancerogene in un tessuto. Gli usi sono i più disparati. Quando carichi una foto su Airbnb, un sistema di AI la analizza per capire se corrisponde alla descrizione che hai dato dell’alloggio. Se hai scritto che c’è la vasca, e invece nella foto c’è una doccia, vieni segnalato. La nostra piattaforma è usata anche nell’analisi degli sport. Le squadre usano per definire le performance dei giocatori in quella determinata partita: ad esempio se stanno correndo o passando la palla più del solito. Il grande vantaggio che abbiamo rispetto ai nostri competitor è che riusciamo a identificare gli elementi con il 98% di accuratezza».

È l’accuratezza la sfida più grande dell’AI?

«La sfida più grande dell’AI è farle capire che non sa tutto. L’AI non sa di non sapere, quindi anche quando è in torto marcio, presenterà una data informazione come se fosse fattuale e verificata. Per questo, ora si sta puntando sulla generalizzazione. Significa imparare da tutto internet e non da una specifica attività. Prima l’AI imparava da un’immagine, ora da uno o anche numerosissimi siti interi. Con tanto di commenti che le danno contesto. E imparano a simulare il pensiero umano».

È questo quello che c’è dietro ai problemi di razzismo e sessismo dei ritratti AI di Lensa?

«L’AI sbaglia perché quello che si trova su internet è contestualizzato male. Il problema di Lensa è che non hanno ancora avuto il tempo di rietichettare questi dati. Hanno usato un crawler – un software che scandaglia le pagine web – che salva le immagini da tutti i siti di arte che trova. Chiaramente l’AI è più propensa a fare quello che trova nel dataset. La maggior parte degli artisti è uomo e bianco e dipinge donne mezze nude. Quelle sono le informazioni che ha ricevuto. La chiave è etichettare in maniera imparziale».

C’è chi teme che certi lavori cambieranno in maniera drastica o addirittura diventeranno inutili a causa dei progressi dell’AI: scrittori, artisti, giornalisti. Nel 2022 esistono applicazioni in grado di ricercare un argomento e scrivere un testo, o di disegnare un’immagine a partire da un comando. Come pensi si evolverà questa situazione?

«Si parla spesso di rimpiazzare il lavoro. ChatGPT – che scrive testi – è molto bravo nella grammatica ma non è fattuale. Se gli chiedi qual è l’animale acquatico più veloce ti risponderà “falco pellegrino”. Insomma, secondo me l’AI diventerà una sorta di copilota. Il volante sarà in mano a un essere umano che ci mette il genio e controlla tutto, mentre l’AI ci mette il minimo comune denominatore tra i prompt (così si definiscono i comandi dati all’AI per farle creare qualcosa) che riceve. Sarà il creatore della brutta copia, ma restano gli umani a doverci mettere il guizzo e renderla la bella copia».

Immagini nell’articolo: V7 Labs