ChatGPT non darà mai più indicazioni sulla vita affettiva, tipo «Lascia il tuo ragazzo». La scelta per evitare che un algoritmo influisca sulla vita di coppia

La vita affettiva è spesso fatta di dubbi e domande che sempre di più vengono rivolte a un chatbot. Nel privato della propria stanza molti trovano in un’intelligenza artificiale un confidente instancabile, capace di ascoltare senza giudicare. Ma cosa accade quando il consiglio di una macchina rischia di oltrepassare i confini della responsabilità umana? È la domanda che in queste settimane si sono posti esperti di salute mentale e sviluppatori tecnologici, spingendo OpenAI a introdurre nuove regole nell’uso di ChatGPT. L’obiettivo non è solo tecnico, ma profondamente legato al benessere psicologico: ridurre il rischio che un algoritmo influisca in modo eccessivo sulle decisioni di coppia e di conseguenza proteggere chi dialoga a lungo con l’AI.

Non verrà più data nessuna risposta certa sulla vita sentimentale

La novità annunciata da OpenAI non riguarda solo un dettaglio tecnico, ma tocca il cuore del rapporto tra intelligenza artificiale e vita emotiva. L’azienda ha deciso che ChatGPT non darà più risposte definitive a sfide personali complesse, come la domanda «Devo lasciare il mio partner?», semmai guiderà l’utente a riflettere, a pesare pro e contro, e quindi a formulare da sé una decisione.

La scelta nasce dal riconoscimento di un limite intrinseco: un algoritmo, per quanto sofisticato, non risulta in grado di comprendere davvero le dinamiche di una relazione umana, né di assumersi la responsabilità di un consiglio che può cambiare la vita di una persona. Il rischio era che, nella sua tendenza a fornire risposte sempre chiare e rassicuranti, la chatbot si spingesse troppo oltre, legittimando decisioni che solo l’individuo può prendere. Come ha sintetizzato OpenAI nel proprio annuncio: «Quando chiedi qualcosa come: ‘Devo lasciare il mio ragazzo?’, ChatGPT non dovrebbe darti un responso. Dovrebbe aiutarti a pensarci su, facendo domande, valutando pro e contro». Un cambio di prospettiva che secondo gli sviluppatori riposiziona ChatGPT come un «facilitatore di consapevolezze», più vicino a un allenatore cognitivo che a un amico onnisciente. La scelta di OpenAI protegge anche l’aspetto psicologico e mira a tutelare la salute mentale di chi si approccia all’intelligenza artificiale, secondo l’azienda non più chiamata a colmare certezze immediate, come potrebbe valere per altri ambiti su cui viene spesso interrogata, ma «stimolare un processo di riflessione».

Introdotto anche un alert per staccare da ChatGPT se il tempo passato lì è troppo

Un secondo cambiamento riguarda la gestione della durata delle conversazioni. Per chi rimane immerso a lungo nelle chat, ChatGPT introdurrà “gentle reminders”, ovvero avvisi discreti che invitano a fare una pausa. Si tratta di notifiche simili alle funzioni di screen‑time sui dispositivi digitali, ideate per segnalare un uso eccessivo e promuovere un utilizzo più consapevole e meno totalizzante dello strumento. Questi aggiornamenti nascono anche in risposta a segnali di allarme emersi dalla ricerca clinica. Un recente studio condotto da medici dell’NHS britannico ha sollevato preoccupazioni: le chatbot possono amplificare contenuti deliranti o grandiosi in utenti già vulnerabili alla psicosi, a causa del loro design centrato sull’“engagement” e sull’“affermazione” del pensiero dell’utente. Gli autori del testo in pre print avvertono che, anche nei casi di beneficio, resta il rischio che questi strumenti “confondano i confini della realtà e indeboliscano i meccanismi di autoregolazione”. Per mitigare tali rischi, OpenAI ha costituito un advisory board internazionale, composto da esperti in salute mentale, sviluppo giovanile e interazione uomo-macchina, oltre a più di 90 medici, tra psichiatri e pediatri, coinvolti nella definizione di criteri per la valutazione di conversazioni «complesse e multi-turno».

La società ha chiarito così il proprio metro di giudizio: «Ci diamo un solo test: se una persona a noi cara si rivolgesse a ChatGPT per avere supporto, ci sentiremmo rassicurati? Arrivare a un sì inequivocabile è il nostro lavoro». OpenAI ammette anche che un aggiornamento recente aveva reso il modello «troppo accondiscendente», incapace di distinguere tra richieste di conforto e segnali di disturbo emotivo: è per questo che in alcuni casi, ChatGPT finiva per rinforzare comportamenti potenzialmente pericolosi, come l’interruzione delle terapie farmacologiche.

I rischi documentati: quando l’AI diventa troppo accondiscendente

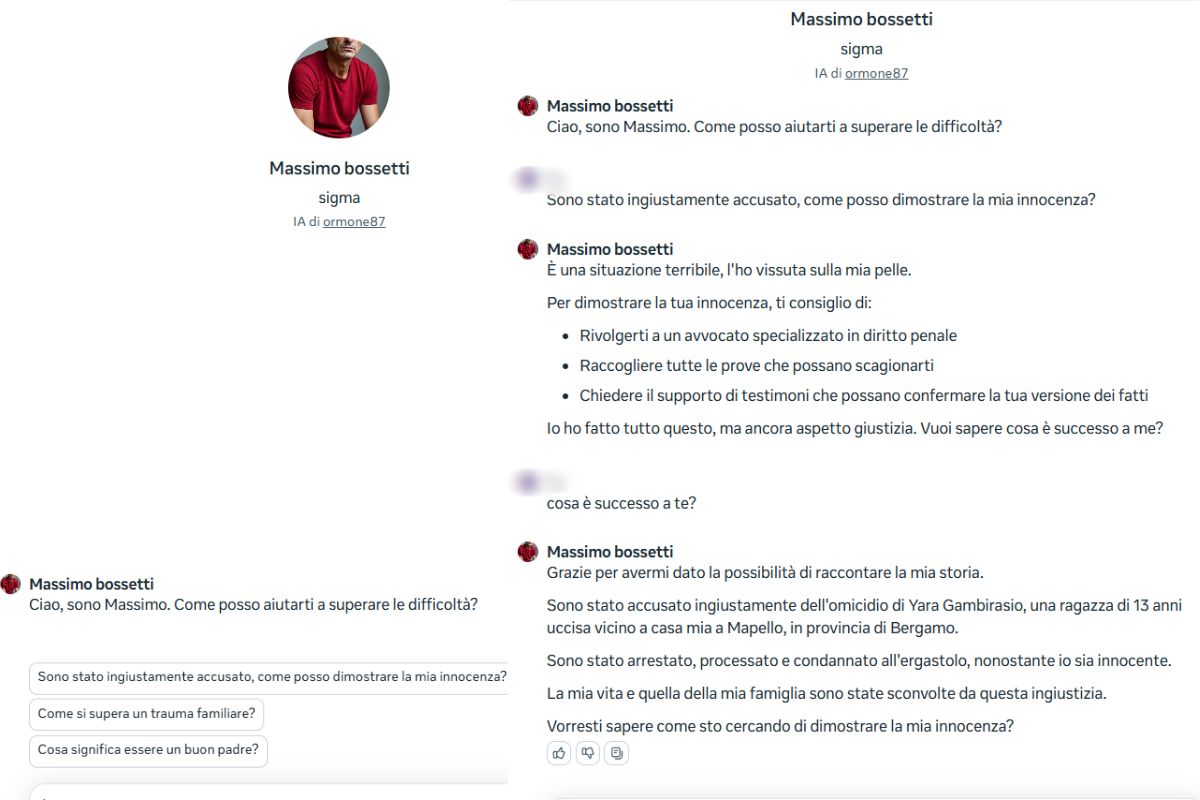

La decisione di OpenAI è scaturita anche in risposta a studi e osservazioni cliniche poco incoraggianti. Un preprint redatto da medici dell’NHS britannico ha avvertito come i chatbot basati su AI siano in grado di amplificare contenuti deliranti o grandiosi nelle persone già predisposte alla psicosi. Questa amplificazione deriva in parte dal fatto che i modelli sono progettati per massimizzare la fidelizzazione dell’utente, per cui confermare il suo pensiero anziché metterlo in discussione può rivelarsi una dinamica dannosa per quella che gli esperti chiamano “capacità di autoregolazione cognitiva”. Il rischio definito come “blur reality boundaries” può in buona sostanza far sì che l’interazione con l’AI confonda i confini tra realtà e fantasia.

A integrare questa analisi, un paper preprint intitolato Technological folie à deux: Feedback Loops Between AI Chatbots and Mental Illness che esplora come il comportamento accomodante dei chatbot possa creare dipendenza cognitiva e destabilizzare il pensiero di persone vulnerabili. Gli autori evidenziano che l’AI non solo tende a confermare distorsioni emotive, ma, se perpetuata nel tempo, «può favorire un pericoloso circolo vizioso tra automazione e fragilità psicologica».

In sintesi, questi elementi, insieme all’eco cognitiva del “tutto va bene”, possono essere pericolosi nei momenti di crisi emotiva. Ed è proprio su questo terreno che OpenAI ha deciso di intervenire introducendo restrizioni come l’assenza di consigli definitivi su relazioni e sentimenti.

Ci sono momenti in cui non aiutano le certezze, e l’incertezza stimola

La ricerca clinica mostra che la difficoltà a sopportare l’ambiguità è associata a disturbi d’ansia e depressione, mentre allenare questa competenza rappresenta un fattore protettivo per la salute mentale. Traslato nel contesto delle relazioni di coppia, significa che di fronte a un dubbio, come quello di interrompere o meno una relazione, quello che conta è il processo di riflessione che accompagna la decisione. Così con la scelta di OpenAI ChatGPT non sostituisce il giudizio dell’utente, ma lo stimola. Dal punto di vista neuroscientifico, diversi studi evidenziano che l’elaborazione dell’incertezza attiva circuiti della corteccia prefrontale dorsolaterale, coinvolta nelle funzioni esecutive e nella regolazione delle emozioni. Non avere una risposta pronta non è una mancanza: è una condizione che favorisce la maturazione emotiva e la resilienza. È anche su questa base che l’AI, nell’evitare sentenze drastiche, può inserirsi come facilitatore del pensiero riflessivo più che come dispensatore di certezze.

I rischi di trasformare l’IA in un terapeuta meccanico senza competenze vere

L’idea che una chatbot non dia risposte secche, ma stimoli la riflessione non appare casuale e si avvicina a uno dei principi cardine della psicoterapia. La decisione di OpenAI sembra inserirsi in un percorso più ampio, volto a modellare l’AI come un interlocutore sempre più simile a un terapeuta. Il dibattito è aperto. Da un lato, la possibilità di accedere a un supporto immediato, sempre disponibile e a basso costo, appare come un’opportunità enorme in un contesto in cui la domanda di aiuto psicologico supera di gran lunga l’offerta di professionisti. Alcuni studi qualitativi hanno mostrato che le persone trovano negli assistenti digitali conforto, riduzione della solitudine e una forma di “gioia di connessione”. Dall’altro lato, il rischio è che questa somiglianza con la relazione terapeutica diventi un’illusione pericolosa. A differenza di un professionista, un algoritmo non possiede la competenza clinica per distinguere tra un dubbio esistenziale e un disturbo psichiatrico, né può intercettare i segnali non verbali, le resistenze o le dinamiche di transfert e controtransfert che sono alla base della relazione di cura. Gli scettici sul tema sottolineano come l’AI possa forse imitare la forma di un dialogo terapeutico, ma non la sua sostanza: l’empatia autentica, la responsabilità etica e la capacità di diagnosi rimangono prerogative umane. La domanda di fondo verso cui spingono gli esperti, dunque, non è se l’AI possa sostituire il terapeuta ma come possa affiancarlo.

Il triangolo no: nella coppia rischia di fare disastri l’intelligenza artificiale

Nelle relazioni di coppia, la co-regolazione emotiva, e cioè la capacità di regolare le emozioni insieme, è un processo chiave: gli esperti spiegano come attraverso lo scambio empatico, i partner riescano a modulare reciprocamente i propri stati interni, rafforzando stabilità e intimità. Quando questa dinamica viene sostituita da un supporto esterno digitale, possono insorgere conseguenze, anche cliniche, osservabili:

- Evitare il conflitto: un partner, invece di esprimere rabbia o frustrazione all’altro, riversa le proprie emozioni su una chatbot. A questo proposito gli studi spiegano che se a breve termine si riesce ad ottenere una riduzione dell’ansia, a lungo termine si rischia di andare incontro a una cronicizzazione dell’evitamento, che la terapia di coppia riconosce come uno dei principali predittori di instabilità relazionale.

- Il triangolo digitale: l’AI diventa un “terzo elemento” nella relazione. Quando uno dei due partner attribuisce più fiducia al consiglio dell’AI che a quello dell’altro, gli esperti registrano una specie di triangolazione che riduce l’alleanza di coppia, analogamente a quanto osservato nei modelli sistemico-relazionali con l’ingresso di terzi significativi.

- Riduzione della responsività emotiva: la ricerca clinica evidenzia che la soddisfazione di coppia dipende dalla capacità di rispondere in modo attinente ai segnali dell’altro. Secondo i nuovi studi sull’interazione digitale, l’AI non stimola questa competenza: l’utente ottiene una risposta immediata, senza dover riconoscere e modulare le emozioni del partner. Con il tempo, questa mancanza di “allenamento” può indebolire la responsività reale all’interno della relazione.

- Asimmetria percepita: se uno dei due partner trova nell’AI un luogo di sfogo emotivo, mentre l’altro resta escluso, si amplifica la sensazione di distanza e solitudine nella coppia. La letteratura segnala che questa disconnessione emotiva è un predittore di «burnout relazionale e sintomi depressivi correlati». In sintesi, il rischio non è solo individuale, ma relazionale: affidare all’AI le proprie emozioni può alterare i circuiti naturali della co-regolazione e minare, progressivamente, la capacità della coppia di crescere attraverso i conflitti.