«Non è un rischio imminente», così OpenAI ignorò l’alert di ChatGPT sulla strage in Canada. Le chat della killer e i dubbi dello staff inascoltati dai capi

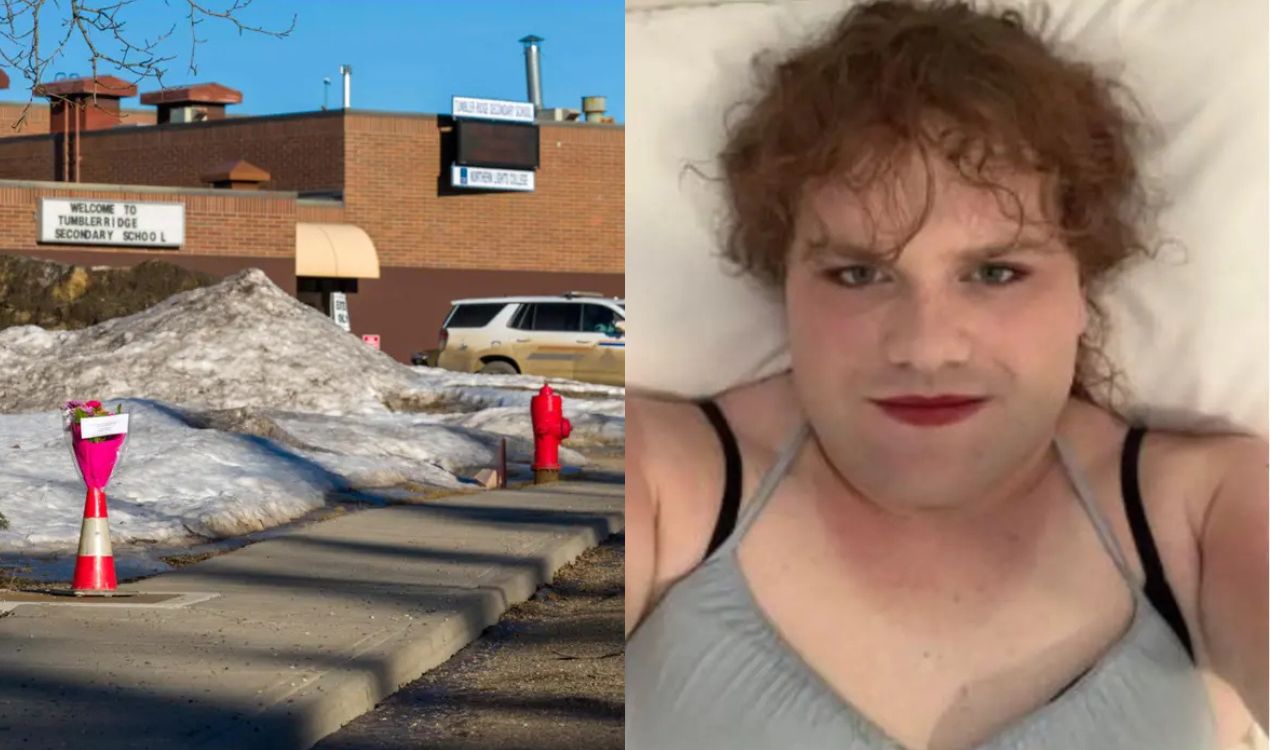

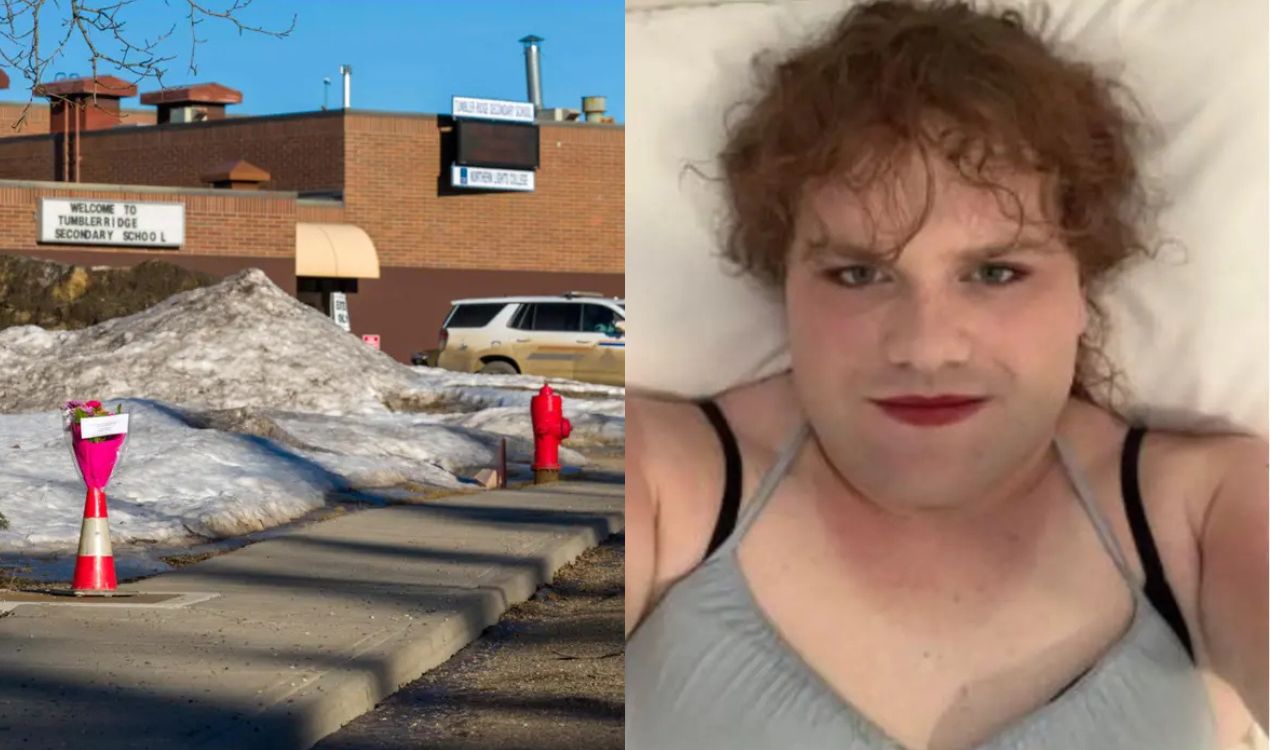

Otto mesi prima di uccidere 8 persone e ferirne 25, la 18enne Jesse Van Rootselaar era stata segnalata dai sistemi di intelligenza artificiale di OpenAI come un soggetto pericoloso. I vertici della società di San Francisco, però, decisero di non avvisare la polizia canadese, limitandosi a chiuderle l’account. È quanto emerge da un’inchiesta del Wall Street Journal che fa luce sulle responsabilità dietro la strage avvenuta il 10 febbraio a Tumbler Ridge, nella Columbia Britannica.

La gestione di OpenAI

A giugno dello scorso anno, Van Rootselaar aveva iniziato a utilizzare ChatGPT per descrivere ripetutamente scenari di sparatorie e violenza armata. Le conversazioni erano state intercettate dai sistemi di revisione automatica di OpenAI, che avevano fatto scattare un alert interno. Secondo le ricostruzioni, diversi membri dello staff dell’azienda avevano analizzato i log delle chat, chiedendo a gran voce di informare le forze dell’ordine. La dirigenza di OpenAI, tuttavia, stabilì che l’attività della ragazza non costituiva un «rischio credibile e imminente di gravi danni fisici», criteri necessari secondo la policy aziendale per procedere alla segnalazione esterna. Venne deciso soltanto il ban dell’utente dalla piattaforma.

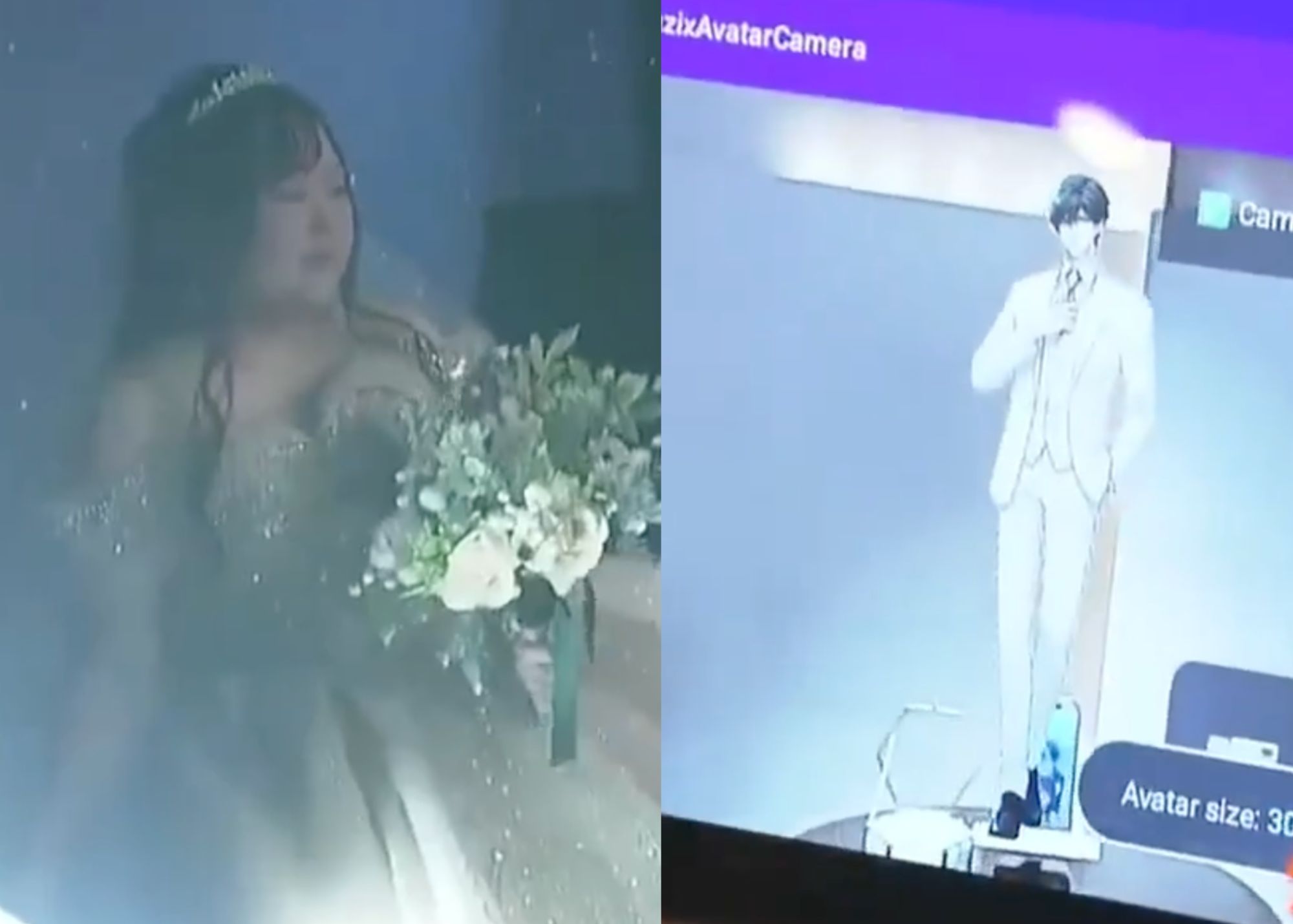

I contenuti online violenti

La valutazione della società si è rivelata fatale. Il 10 febbraio, la 18enne ha aperto il fuoco all’interno di una scuola e contro i propri familiari, uccidendo 8 persone prima di togliersi la vita. Solo a massacro compiuto OpenAI ha contattato la Royal Canadian Mounted Police per rivelare i precedenti allarmi generati dal chatbot. Le indagini hanno poi confermato che le intenzioni della 18enne erano visibili anche su altre piattaforme. Su Roblox, ad esempio, aveva sviluppato un software che simulava una sparatoria in un centro commerciale, sui social circolavano video di lei intenta a esercitarsi in un poligono di tiro, e spesso partecipava attivamente a forum su YouTube dedicati ad armi da fuoco. «I nostri pensieri vanno a tutti coloro che sono stati colpiti dalla tragedia di Tumbler Ridge», ha dichiarato un portavoce dell’azienda di AI.